O que é Robots.txt? Entenda como ele pode melhorar seu SEO

O que é Robots.txt? Entenda como ele pode melhorar seu SEO

O robots.txt é um dos arquivos mais fundamentais para o controle de rastreamento de sites, mas também um dos menos compreendidos. Se você quer otimizar o desempenho do seu site nos mecanismos de busca, precisa conhecer essa ferramenta a fundo. Neste artigo vamos explorar em detalhes como o robots.txt funciona e como utilizá-lo corretamente para beneficiar sua estratégia de SEO.

O que é o robots.txt?

O arquivo robots.txt é um simples arquivo de texto localizado no diretório raiz de um site. Seu principal papel é fornecer diretrizes para rastreadores sobre quais páginas ou seções do site podem ser acessadas e indexadas. Para visualizá-lo, basta adicionar “/robots.txt” ao final do nome de domínio do site. Exemplo: meusite.com/robots.txt.

Geralmente, sistemas de gerenciamento de conteúdo (CMS) como WordPress, Shopify e outros criam esse arquivo automaticamente. No entanto, personalizá-lo pode ser uma grande vantagem para otimizar o rastreamento do seu site.

Para que serve o robots.txt?

A função principal do robots.txt é orientar os mecanismos de busca sobre quais áreas de um site devem ou não ser rastreadas. Entre suas principais utilizações estão:

- Bloquear rastreamento de páginas sensíveis (como áreas de login e administração);

- Evitar a indexação de páginas duplicadas ou sem valor para SEO;

- Direcionar os rastreadores para o sitemap XML do site, auxiliando na indexação eficiente;

- Controlar a carga no servidor ao restringir rastreamento excessivo.

Como os rastreadores interpretam o robots.txt?

Os mecanismos de busca seguem as regras definidas no robots.txt por boa prática, mas vale lembrar que isso não é uma segurança absoluta. Qualquer um pode visualizar e ignorar essas diretrizes se desejar. Por isso, para restringir realmente o acesso a determinadas áreas, é recomendável usar autenticação via senha ou regras no servidor.

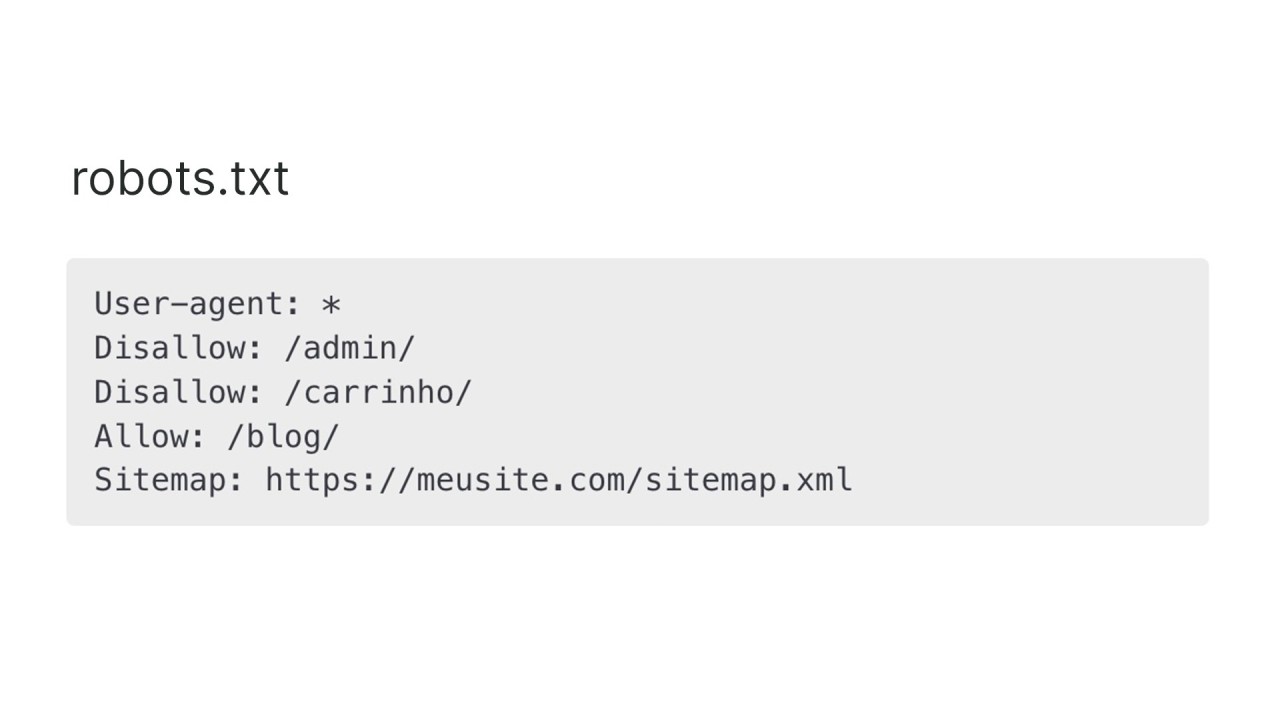

Os rastreadores interpretam as diretivas de permissão e bloqueio baseadas nos seguintes comandos principais:

- User-agent: Define para qual robô a regra se aplica.

- Disallow: Indica quais páginas ou diretórios não devem ser rastreados.

- Allow: Permite o rastreamento de um caminho específico dentro de um diretório bloqueado.

- Sitemap: Informa a URL do sitemap do site para facilitar a indexação.

Exemplo de um arquivo robots.txt padrão:

User-agent: * Disallow: /admin/ Disallow: /carrinho/ Allow: /blog/ Sitemap: https://meusite.com/sitemap.xml

Robots.txt e SEO: O que você precisa saber

Para quem trabalha com SEO, um robots.txt bem configurado pode melhorar significativamente a eficiência do rastreamento e indexação. Algumas boas práticas incluem:

- Evite bloquear arquivos CSS e JavaScript: Bloquear esses arquivos pode dificultar o entendimento da estrutura do site pelos buscadores.

- Use o robots.txt para otimizar o orçamento de rastreamento: Se o Googlebot gastar tempo rastreando páginas sem importância, menos recursos serão usados para indexar conteúdo valioso.

- Combine com a tag meta robots: Se você quer evitar a indexação de uma página específica sem impedir seu rastreamento, a meta tag robots no cabeçalho HTML é a melhor opção.

O futuro do robots.txt

Desde sua criação em 1994, o robots.txt se manteve uma das ferramentas essenciais para o funcionamento da Web. Com a evolução das buscas, surgiram extensões como o suporte às diretrizes sitemap e ao rastreamento de novos tipos de agentes, incluindo aqueles usados para IA e machine learning.

Como o SEO está em constante evolução, entender o funcionamento do robots.txt é essencial para qualquer especialista que queira garantir que seu site seja bem interpretado pelos mecanismos de busca.

Caso tenha dúvidas ou queira acrescentar algo, deixe um comentário.